告别调图卡顿!PACS影像调阅进入“高铁”时代!

PACS调图卡顿成为常态

医疗影像检查技术发展日新月异,设备分辨率越来越高。CT检查设备从早期的64排已经发展到256排;人工智能图像识别广泛使用,扫描切层厚度从5mm 减小到1mm。为了给患者提供更好的服务,医院不断引入新的检查设备。这些因素使得PACS影像数据量急速增加。

- 10年前,一位患者检查产生的CT图像大约几百张,数据量不到100M, 调图时间只需要2~5秒。

- 10年过去了,患者一次检查产生的图像数量增长到3000幅以上,数据量达到1G。数据量增长了10倍,调图时间长达2~3分钟!

PACS影像数据在飞速增长,但是存储设备的性能并没有提高;不仅没有提高,还在下降!存储设备中的数据越多,读取的速度越慢。

为了解决PACS影像调图性能的问题,医院、PACS厂商、存储设备厂商十八般武艺轮番上阵,但基本思路都是把存储分为在线、近线、离线三层。最近几个月的热数据保存到在线存储,通常为FC-SAN存储,硬件配置高,数据量少,保证设备性能达到良好;近线存储用中低端NAS存储,离线存储使用磁盘库……

但是,由于PACS数据量的增长,性能问题越来越严重,图片调阅卡顿成为常态;数据要不断迁移;调取历史影像极为不便……

PACS影像调阅进入“高铁”时代

在过去的10年里,存储技术发展获得突破,分布式存储技术日渐成熟,为PACS影像存储提供了革新的方案。

霄云科技研发的碧海分布式存储系统,采用一系列创新技术,突破了传统集中式存储的性能和容量瓶颈;针对PACS影像的海量小文件特征进行深度优化,彻底解决PACS影像数据存储的挑战:

1、PACS影像调图速度提高到300幅/秒!提升3~10倍!

2、1000幅的CT图像,只需要3秒就可以调取完成!调图再也不卡顿!

3、只需一套存储,数据全部在线高速调取,再也不要做数据迁移了!

4、很多医生电脑同时访问时会不会变慢?

碧海存储可以支持高达10000个并发连接,小文件读取总吞吐率超过1GB/s,可以保证医院工作高峰期间几百台电脑同时高速调阅;

5、以后数据量增多时会不会变慢?

大型3甲医院每年生产的PACS文件数为2亿左右。碧海存储写入100亿文件,读写性能衰减小于10%!

与其他存储对比

对比传统存储和开源软件类存储,碧海分布式存储有以下核心优势:

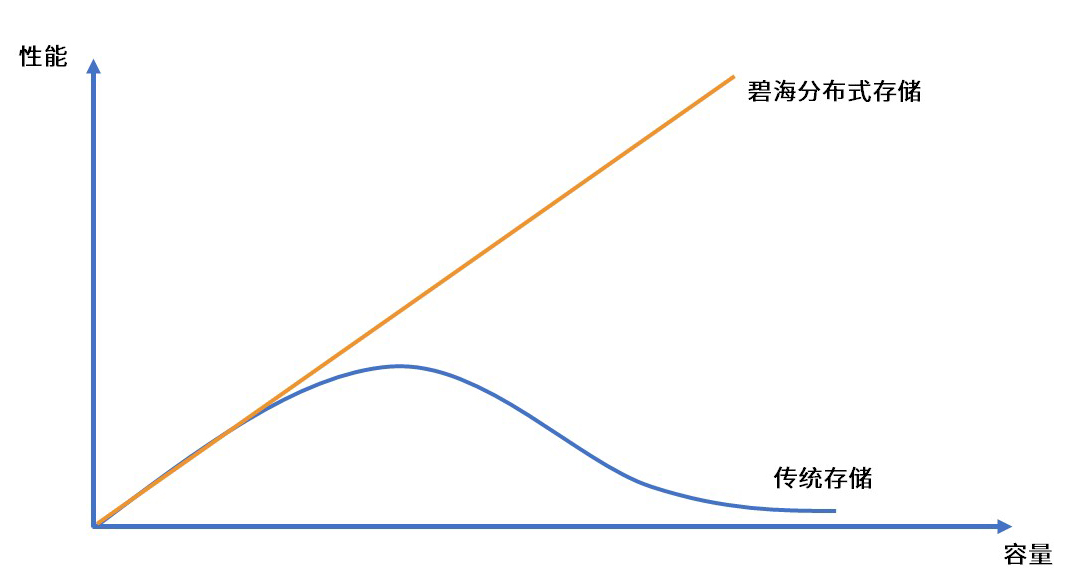

可扩展性不同

传统存储的性能随容量增加而下降;碧海分布式存储的性能随容量增加而提升。

▲可扩展性

性能变化趋势不同

传统存储随着文件数量的增长性能下降,可管理文件数在亿级;

Ceph在文件数量达到10亿时性能下降75%;

碧海存储在文件数量达到100亿级时性能下降小于10%。

▲文件数量与性能

技术秘笈

碧海分布式存储系统的IO路径做了全面优化,才获得良好的性能。最重要的技术点包括:

1、分布式架构, 将数据管理的负载均衡分布到很多个存储节点上,存储节点之间松耦合。增加存储节点,容量和性能同步提升;

2、采用分布式方式管理元数据;

3、针对PACS影像的小文件特征进行深度优化,实时聚合后写入磁盘,减少了元数据管理负载,也减少了磁盘寻道次数;

4、取消传统RAID,磁盘独立并发访问,释放磁盘IOPS性能;

5、使用异步编程模型,支持更高的并发连接数和并发IO,而且连接数增多时性能不下降;

6、自主研发,不基于开源软件,掌握核心技术,产品稳定有保障。

上海市胸科医院是国内胸外科医院,每年手术量达到18000例。每天CT检查量超过1000例,核磁MRI检查超过100例。由于所有患者都需要定期做CT检查,因此PACS数据量很大,每年达到80TB,对阅片调阅性能要求很高。

为了更好地支持一线医生的工作,上海市胸科医院信息科不断探索引进新的先进技术。2019年对碧海分布式存储进行了1年性能和可靠性测试,2020年正式上线,2021年初扩容,目前在线数据量达到400T,文件数量接近9亿。

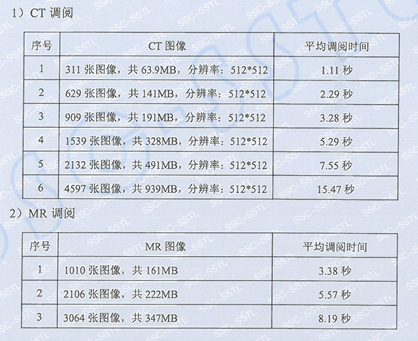

2021年4月,上海市软件测评中心在医院现场对PACS影像调图性能进行了评测,结果如下: